Pronosticar el comportamiento futuro de la atmósfera nunca fue una tarea fácil. La atmósfera tiene sus propias leyes y responde a la física que está expresada en ecuaciones matemáticas muy complejas. Estas ecuaciones son las que describen su comportamiento, pero no tienen solución analítica; esto quiere decir que para poder resolverlas es necesario simplificarlas o realizar aproximaciones.

Los inicios

El primero en darse cuenta de esto, a principios del siglo XX, fue Vilhelm Bjerknes, un meteorólogo noruego que desarrolló las ecuaciones de movimiento de la atmósfera que se siguen utilizando hasta el día de hoy. Planteó que para poder realizar un pronóstico era necesario conocer el estado actual de la atmósfera con la mayor precisión posible, ya que para resolver las ecuaciones en un tiempo futuro era necesario “alimentarlas” con datos observados del tiempo presente.

Unos años más tarde, el meteorólogo inglés Lewis Fry Richardson tomó la posta que dejó Bjerknes e intentó realizar un pronóstico del tiempo utilizando las ecuaciones planteadas por el noruego, con algunas aproximaciones e introduciendo un método numérico para poder resolverlas analíticamente. Luego, publicó los resultados que obtuvo al hacer manualmente un pronóstico a 6 horas para una región de Francia. El resultado fue poco alentador, ya que por un lado tardó varias semanas en obtenerlo y, por otro lado, sus conclusiones fueron poco realistas.

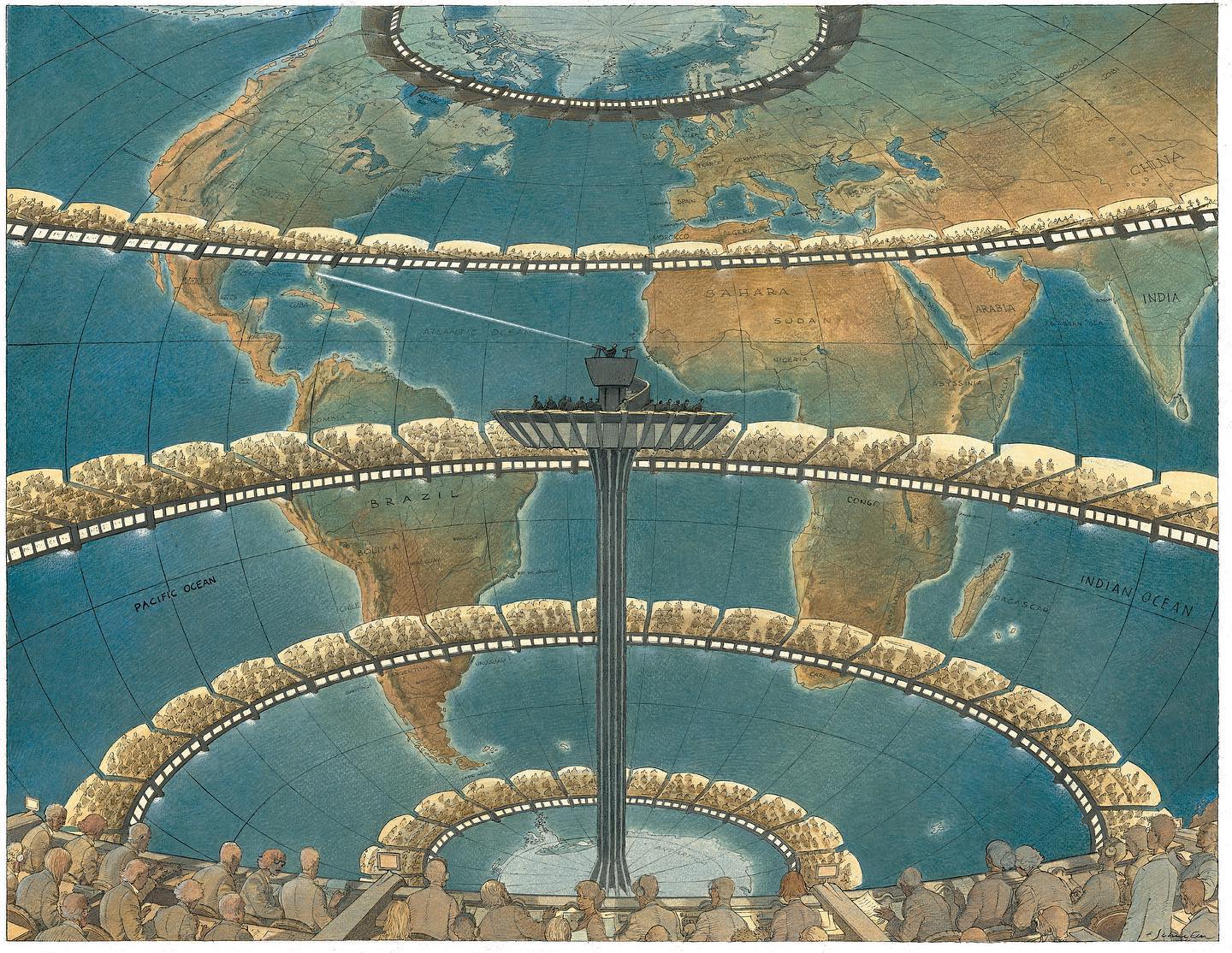

Richardson planteó que para poder realizar un pronóstico en plazos útiles (porque si un humano tarda semanas para obtener un pronóstico a 6 horas, resultaría totalmente inútil, pues el plazo ya habría pasado) se necesitaría lo que él llamó una “fábrica del tiempo”. Esto es, nada más y nada menos que unas 64 mil personas resolviendo en simultáneo y de forma sincronizada las ecuaciones mencionadas para poder hacerlo con mayor rapidez que la evolución de la atmósfera.

Claramente esto no era realizable, y él lo tenía claro, por eso dejó asentado en su libro de 1922: “quizás algún día en el futuro (…) será posible avanzar en los cálculos más rápidamente de lo que avanzan las condiciones meteorológicas (…). Pero eso es un sueño”.

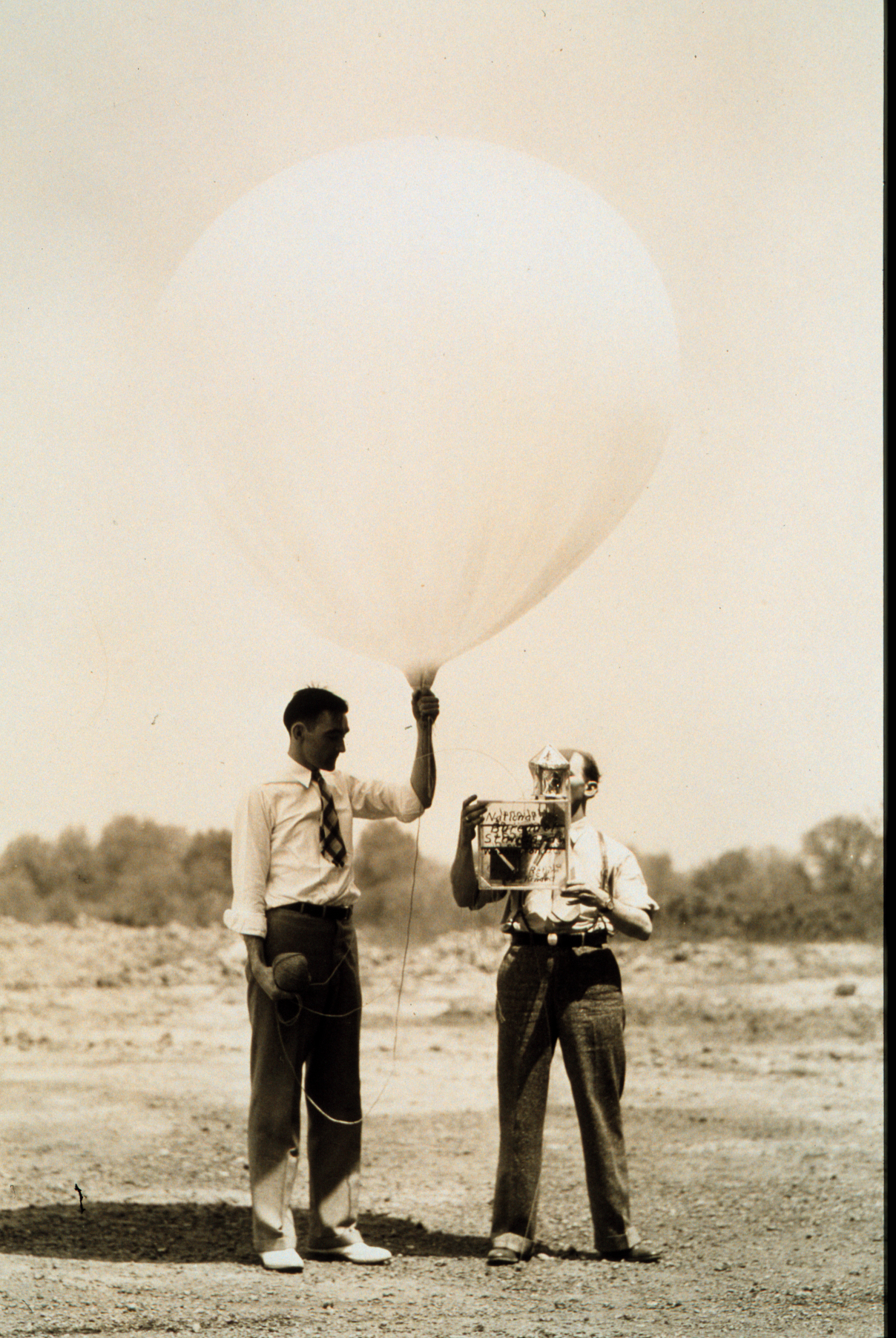

Durante las décadas siguientes se inventaron los radiosondas, que permitieron obtener mediciones de la atmósfera en altura, y se desarrollaron las primeras computadoras que garantizaban cálculos en menores tiempos que un humano. Utilizando este avance en las observaciones y en la tecnología, Jule Charney, un meteorólogo estadounidense, junto a un equipo de investigadores, retomaron el problema del pronóstico meteorológico. Para este intento propusieron una simplificación del sistema de ecuaciones de la atmósfera para utilizar menos recursos computacionales, y así obtuvieron el primer pronóstico a 24 horas en 1950.

El éxito de dicho pronóstico motivó a que se continuase con estos experimentos en diferentes partes del mundo, probando diferentes tipos de aproximaciones o simplificaciones, hasta que en 1954 bajo la dirección del meteorólogo estadounidense de origen sueco Carl-Gustaf Rossby, el Servicio Meteorológico de Suecia puso en práctica el primer pronóstico operativo, seguido por Estados Unidos unos meses más tarde. El sueño de Richardson se había cumplido y nacían así los primeros modelos numéricos de predicción del tiempo, pero ¿qué es un modelo numérico?

Modelando la atmósfera

Un modelo numérico de predicción del tiempo es un software de computación que es capaz de resolver las ecuaciones físicas que rigen los movimientos de la atmósfera en tiempos en los que un humano no podría. Puede simular, dadas las observaciones meteorológicas de un día, la evolución de la atmósfera en las próximas horas, días o incluso meses. Como pudo comprobar Richardson, la resolución matemática de las ecuaciones mencionadas resultaría inútil si se hiciesen los cálculos manualmente y muy engorrosa si no se realizaran aproximaciones.

Las aproximaciones consisten en asumir determinados valores de algunas variables en algunos casos, o asumir determinados comportamientos de la atmósfera en otros, los cuales no siempre se cumplen o, simplemente, no se conocen. Esta forma de simplificar el sistema de ecuaciones, imperfecta pero necesaria, sumada a la naturaleza caótica de la atmósfera traen aparejados errores que se trasladan al pronóstico, lo cual implica una limitación, tanto en el plazo de validez del pronóstico como en la calidad del mismo.

Si bien los primeros pronósticos se realizaban para áreas pequeñas, o sólo para el hemisferio norte, a medida que avanzaba la tecnología y la capacidad de cómputo, se pudo lograr el primer pronóstico para toda la Tierra, utilizando un modelo numérico global. El mismo fue implementado en el año 1965 por Joseph Smagorinsky y su equipo del Laboratorio Geofísico de Dinámica de Fluidos (GFDL, por sus siglas en inglés) de la Administración Nacional Oceánica y Atmosférica (NOAA), de Estados Unidos. A fines de la década del 60, en el GFDL se desarrollaron los primeros modelos numéricos globales acoplados con el océano, lo que permitió no solo simular el tiempo, sino también el clima en interacción con fenómenos como El Niño/La Niña, entre otros.

Por otro lado, para intentar reducir los errores aparecieron los primeros pronósticos por conjunto o ensambles, que se empezaron a realizar de forma cuasi-operativa en 1985 en la oficina Meteorológica del Reino Unido (MetOffice, por su nombre en inglés) a plazos mensuales. Unos años más tarde, en 1992, el Centro Europeo de Pronósticos de Mediano Plazo (ECMWF, por sus siglas en inglés) comenzó a generar pronósticos por conjunto operativos en el corto y mediano plazo, casi al mismo tiempo que el Centro Nacional de Predicción Ambiental (NCEP) de la NOAA. Si bien llevó varios años implementarlo para el resto de los países por el alto costo computacional, hoy en día todos los centros globales utilizan este tipo de pronóstico de forma operativa.

La calidad de los pronósticos numéricos también fue mejorando a medida que aumentaba la cantidad y la calidad de las observaciones. Así como la aparición de los radiosondeos produjo un avance del modelado numérico, la era satelital en los 70 fue otro hito que permitió obtener conocimiento de regiones remotas del globo y de los océanos, lo cual se tradujo en un gran salto en la evolución del pronóstico numérico del tiempo. Por eso, la mejora de los modelos numéricos operativos se vincula no solo con un mayor conocimiento de los procesos físicos que controlan el comportamiento de la atmósfera a través de las observaciones, sino también con el desarrollo tecnológico.

¿Y en Argentina?

En nuestro país, gracias a la adquisición de “Clementina”, la primera computadora que se utilizó con fines científicos en la Facultad de Ciencias Exactas y Naturales de la Universidad de Buenos Aires (UBA), se pudieron hacer los primeros experimentos en modelado numérico de la atmósfera hacia finales de los 60. Los primeros modelos desarrollados localmente eran muy simplificados debido a que la tecnología computacional de esa época imponía una limitación en la capacidad de cómputo.

Gracias a la adquisición de “Clementina”, la primera computadora que se utilizó con fines científicos en la Facultad de Ciencias Exactas y Naturales de la Universidad de Buenos Aires (UBA), se pudieron hacer los primeros experimentos en modelado numérico de la atmósfera hacia finales de los 60.

Durante las décadas del 70 y el 80, los investigadores de diferentes organismos continuaron desarrollando modelos numéricos o bien realizando pruebas con los ajustes necesarios para un mejor desempeño sobre nuestra región. Por ejemplo, la inclusión de la cordillera de los Andes en un modelo numérico no era una cuestión sencilla, ya que suelen tener problemas en representar bien las regiones montañosas. Tal es así que hasta el día de hoy no existe un modelo numérico que represente las cadenas montañosas de forma exacta, por lo cual se continúan realizando esfuerzos para mejorar en este aspecto. Lo de la cordillera es sólo un ejemplo de las complicaciones que existen y es necesario abordar; lo mismo pasa con diversos fenómenos meteorológicos como por ejemplo la correcta representación de las nubes y la física dentro de ellas, la posición de algunos sistemas como ciclones o anticiclones y ni hablar de los errores en el pronóstico de la precipitación, la variable más compleja de esta ciencia.

Tanto en el Departamento de Ciencias de la Atmósfera y los Océanos (DCAO) de la UBA, el Centro de Investigación del Mar y la Atmósfera (CIMA) como en el Servicio Meteorológico Nacional (SMN), se continuó trabajando en el modelado numérico. A través de los años, se lograron continuos avances como por ejemplo la implementación de modelos regionales entre los 80 y 90 en el CIMA, o la implementación en el SMN del primer pronóstico numérico operativo, a 24 horas, en 1986. Con los años, los modelos numéricos se fueron reemplazando a medida que iban mejorando, como por ejemplo el modelo ETA-SMN, que comenzó a utilizarse en el año 2003. En aquel momento, ese era un modelo conveniente para regiones con topografía abrupta como la cordillera de los Andes.

En el año 2005 el CIMA comenzó a utilizar el modelo modelo regional de Investigación y Pronóstico Meteorológico (WRF, por su nombre en inglés), mientras que en el SMN dicho modelo se implementó a partir de 2012 en modo experimental. En 2017 pasó a fase operativa y al año siguiente, con la adquisición de un equipo de cómputo de alto rendimiento (HPC) se pudieron realizar las primeras pruebas de pronósticos por ensambles con el modelo WRF en el SMN. En octubre de 2019, estos pronósticos por conjuntos pasaron a fase operativa y están disponibles en la web de dicho organismo.

Hoy en día es difícil pensar en un pronóstico meteorológico sin pensar en un modelo numérico. Pero para llegar al estado del arte actual del pronóstico tuvo que correr mucha agua bajo el puente, ya que implicó numerosos esfuerzos, investigaciones y pruebas y errores durante décadas. No obstante, consideramos que para realizar un pronóstico de calidad es fundamental la presencia de pronosticadores, entrenados en reconocer los errores sistemáticos y en interpretar las salidas de los modelos. Nuestro país tiene un recorrido en cuanto al desarrollo e implementación de modelos numéricos cada vez más complejos y es un camino que seguimos transitando.

Fuentes consultadas:

-

Kalnay, E. (2003), Atmospheric Modeling, Data Assimilation and Predictability. Cambridge University Press, 341 pp.

-

Meteoros 2012, año 6, número 1. Repositorio Institucional del SMN (http://hdl.handle.net/20.500.12160/1101)

-

Palmer, T. (2018), The ECMWF ensemble prediction system: Looking back (more than) 25 years and projecting forward 25 years. Quarterly Journal of the Royal Meteorological Society.

-

Richardson, L. F. (1922), Weather prediction by numerical process. Cambridge University Press. (https://archive.org/details/weatherpredictio00richrich/page/n8/mode/2up)